▹ News : Ray 2, le nouveau modèle vidéo de Luma

▹ Zoom : Omi, précurseur de l'interface cerveau-machine

▹ Deep Dive : Vidéo IA - 6 incroyables outils et leurs usages phares.

Salut à tous,

Quel jour de l'année les gens abandonnent-ils en moyenne leurs résolutions ? Réponse : le 19 janvier.

Ce n'est pas moi qui le dit, mais ChatGPT (à prendre avec des pincettes, donc).

Du coup, si vous avez craqué hier et commandé une pizza triple fromage en annulant votre abonnement à la salle de sport… sachez que vous êtes statistiquement normaux.

Dans tous les cas, je ne vous jugerai pas. Ni ChatGPT d'ailleurs. Après tout, lui aussi a parfois besoin d’une mise à jour pour tenir ses objectifs (et corriger sa paresse chronique).

C'est le blue monday aujourd'hui, alors on est doux avec soi-même (et avec les autres). Bonne semaine !

Sane de Upmynt 💜

🎬 Ray 2. Luma Labs dévoile Ray 2, un modèle capable de générer des vidéos de 10 secondes avec une qualité de mouvement et un réalisme physique améliorés, grâce à une puissance de calcul supposément 10x supérieure à son prédécesseur.

- Génération de vidéos à partir de texte, d’images ou d’autres vidéos.

- Maîtrise avancée des mouvements complexes et des interactions physiques (fluides, mouvements humains).

- Disponible via la plateforme Luma Dream Machine pour les abonnés.

😬 Ah, Copilot… Copilot serait désormais accessible à tous les clients (particuliers et pros) à Microsoft 365.

À quoi s'attendre ? En gros, un équivalent de ChatGPT (la bête est censée tourner sur GPT-4o), en moins pratique et avec moins de fonctionnalités. Enjoy !

L'usage de Copilot embarqué dans les outils de la suite Office (Word, Excel, Powerpoint, etc.) est aussi inclus. Mais là aussi, c'est bourré de bugs, donc pas de quoi se réjouir outre mesure.

Du coup, je me demande légitimement : pourquoi encore payer pour la brique "Copilot Pro" si Copilot est désormais inclus par défaut ? Réponse de Microsoft : « Notre offre Copilot Pro, lancée en janvier 2024, reste disponible pour les utilisateurs ayant des besoins avancés ». Mmmh, okay.

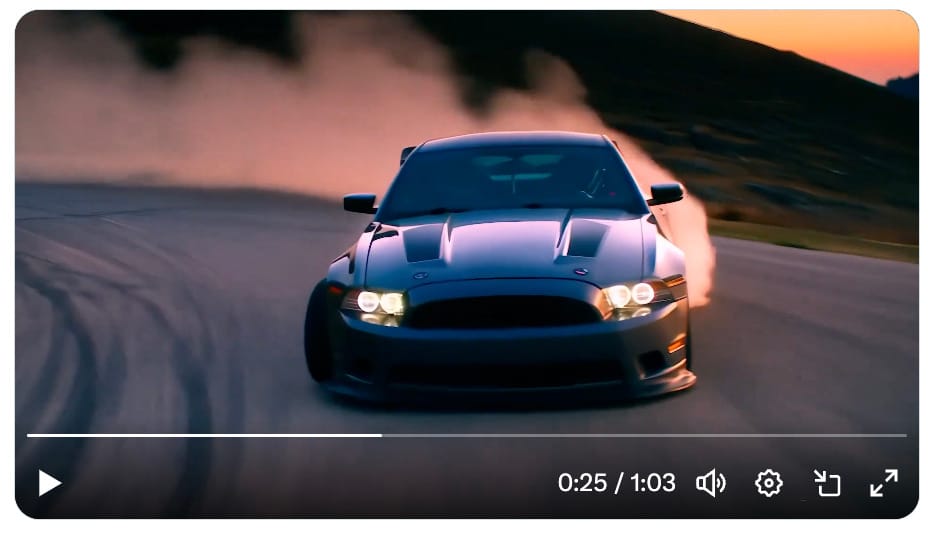

😼 Le Chat x AFP. L'une des plus grosses agences de presse mondiales est française, il s'agit de l'AFP. Et c'est donc un partenariat IA tricolore qui se dessine ici, puisque les dépêches de l'AFP seront désormais accessibles et réutilisables par Le Chat, l'assistant IA du développeur français Mistral.

« Dans un monde inondé d’informations, l’intégration des contenus de l’AFP permettra d’offrir aux utilisateurs du Chat des réponses plus riches et plus précises. »

Le tout sera live dans les prochaines semaines. Comptez sur moi pour vous le notifier !

Visualisez la démo de la bête, diffusée dans l'émission de France 5 "C à Vous" (à partir de 2'45").

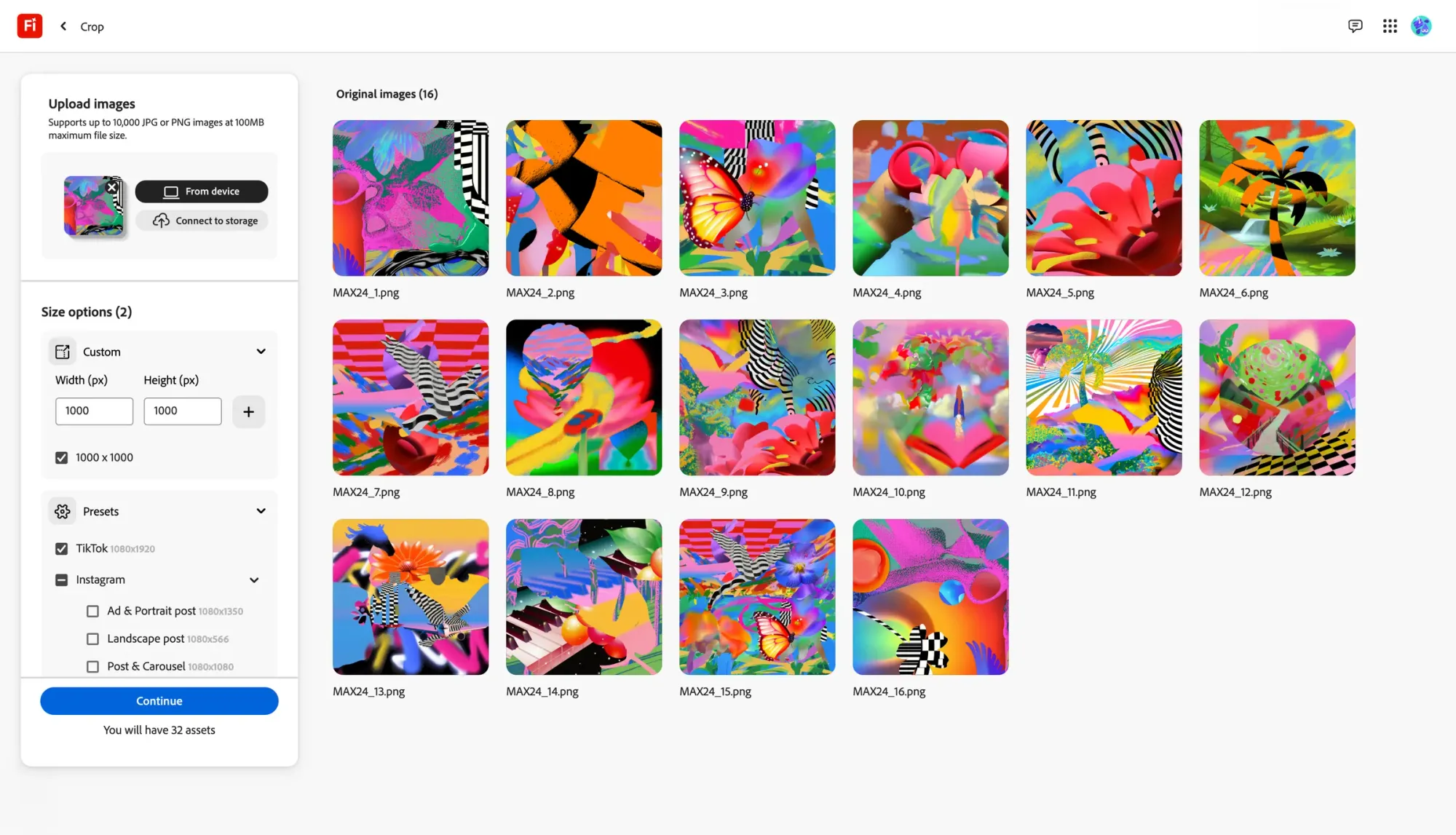

🖱️ Pratique. Adobe a annoncé un nouvel outil "Bulk Create" permettant de redimensionner d'un seul clic des milliers d'images.

L'outil embarque une sélection d'options prédéfinies pour les tailles de bannières publicitaires et les plateformes les plus populaires, comme TikTok, Instagram et FB.

Lorsque cela est nécessaire, il utilise l'IA générative pour étirer les arrière-plans des images afin de les adapter aux dimensions requises.

D'après le journaliste de The Verge qui a vu une démo, le résultat n'est pas toujours garanti, mais gageons qu'il est plus rapide d'ajuster les quelques bavures plutôt que de procéder à tous les redimensionnements un à un.

L'outil n'est dispo qu'en beta aux US mais son lancement en Europe est certainement imminent.

▹ Sondage

Un petit sondage pour tâter un peu le ressenti terrain !

Quel développement ou évolution en cours de l'IA vous enthousiasme le plus pour 2025 ?

Un seul clic suffit. Plus vous êtes nombreux à voter, plus le résultat sera représentatif.

Cet espace "Communauté" est le vôtre. Répondez à cet email avec votre besoin : Recrutement, ressource à partager, demande d'aide, question…

Omi, précurseur de l'interface cerveau-machine

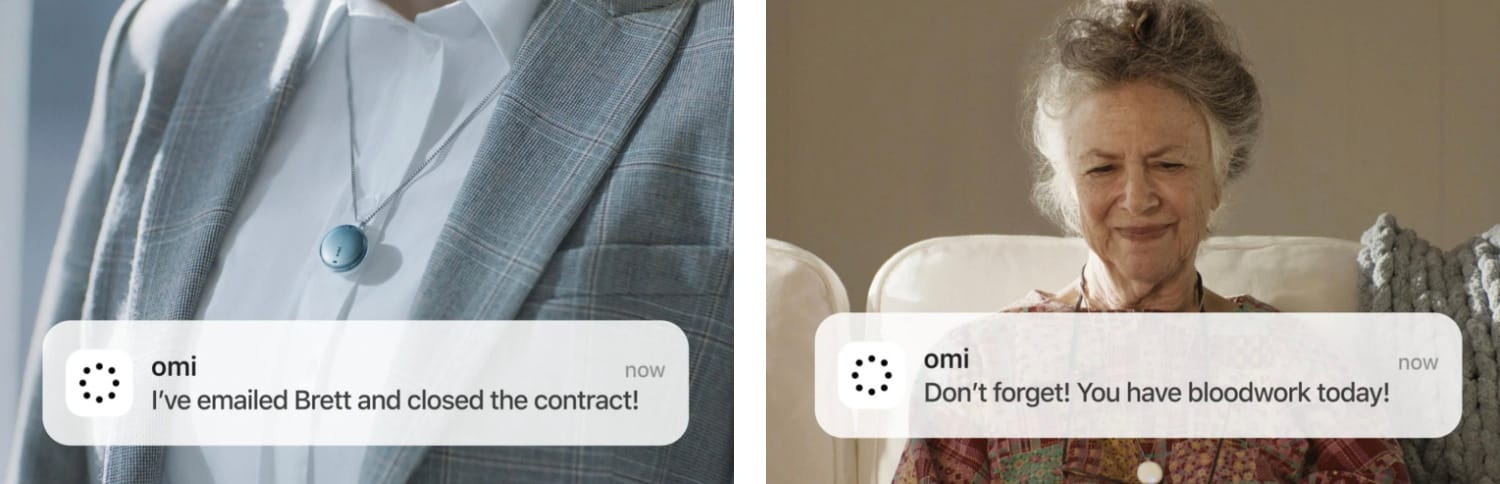

Peut-être avez-vous vu passé la news au sujet de Omi ; il s'agit d'un appareil portable innovant dévoilé lors du CES, conçu pour enrichir les interactions humaines grâce à l'IA. Trailer d'annonce.

De la taille d'une grande pièce de monnaie, il peut être porté en pendentif ou fixé sur la tempe à l'aide d'un ruban adhésif médical.

▹ Omi : pour quoi faire ?

Sa principale fonction est d'écouter les conversations en temps réel, d'analyser les infos échangées et de fournir des résumés intelligents ou des données complémentaires sur les sujets abordés.

👉 Par exemple, si vous discutez d'un produit spécifique, Omi peut envoyer une notification détaillant ses performances, avantages et inconvénients.

Omi est autonome et peut aussi réagir en direct à votre environnement sonore et vous proposer spontanément des recommandations, comme l'illustre cet exemple (un peu cheesy) communiqué par Omi :

▹ L'essentiel sur Omi

- Durée de vie de la batterie : Jusqu’à trois jours sur une seule charge.

- Prix annoncé de $89.

- Disponibilité prévue pour le deuxième trimestre 2025.

- Pré-résa possible sur le site officiel.

▹ Un module d'interface cérébrale pour bientôt

Actuellement, Omi se limite à l'audio, mais un module d'interface cérébrale est prévu dès le 2e trimestre 2025, et c'est là que la bête pourrait révéler son potentiel.

Ce module permettrait de lire les signaux cérébraux grâce à une seule électrode placée sur la tempe, offrant ainsi la possibilité de comprendre certaines de vos pensées sans nécessiter de commandes vocales.

Contrairement à des initiatives comme Neuralink, qui nécessitent l'implantation de puces dans le cerveau , Omi mise sur une approche non invasive, qui pourrait changer la donne.

▹ Le potentiel énorme de l'interface cerveau - machine

L’utilisation d’électrodes dans le cerveau permet non seulement d’enregistrer directement l’activité des neurones individuels, mais aussi de les stimuler. Sauf que… personne ne veut subir une opération invasive.

Cela sera probablement résolu par des électrodes nanométriques inoffensives insérées dans le cerveau par la circulation sanguine.

Pour stimuler le cerveau, une interface pratique nécessiterait de fonctionner à sa vitesse d'origine, à savoir des dizaines de millions de connexions simultanées. Dans les années 2030, nous atteindrons cet objectif en utilisant des appareils microscopiques appelés nanobots.

Vous souvenez-vous de ce qui s’est passé il y a 2M d’années, la dernière fois que nous avons gagné plus de néocortex ? Nous sommes devenus des humains.

Lorsque nous pourrons accéder à un néocortex supplémentaire dans le cloud, le saut dans l’abstraction cognitive sera probablement similaire. Résultat : l’invention de moyens d’expression bien plus riches que la technologie possible aujourd’hui.

▹ Omi : un signal faible d'une révolution future

Omi ne sera pas capable de stimuler les neurones, mais sa capacité à lire certaines de leurs activités à l'aide d'une simple électrode sur la tempe (= non invasive) est une promesse ambitieuse, qui préfigure l'avenir des interfaces humain-IA.

Bien sûr, cela lève de gigantesques questions sur la confidentialité des données. Mais attentons de voir ce dont Omi est vraiment capable, et comment sont traitées les données en question, avant de crier au loup. À suivre, donc…

Vidéo IA : 6 incroyables outils et leurs usages phares

Les outils IA se multiplient et ils ne cessent tous de s'améliorer. Afin de vous aider à vous retrouver, je vous livre 7 nouveaux usages phares proposés par les générateurs vidéo !

▹ Hailuo : l'incroyable fonctionnalité "sujet référent"

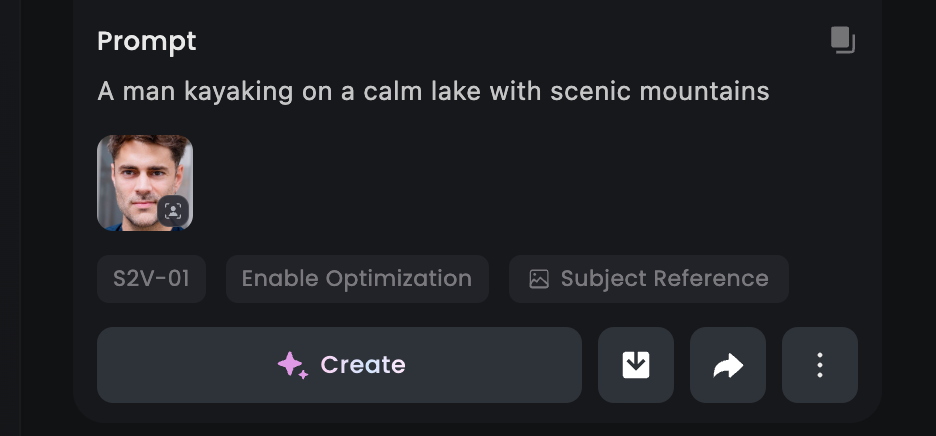

Le générateur vidéo chinois Hailuo propose désormais la "Subject Reference" afin d'animer n'importe quelle personne sur la base d'une simple photo de son visage.

Il suffit de choisir le modèle S2V-01, et de simplement attacher à votre prompt une image type photo d'identité. Ensuite, mieux vaut opter pour un prompt simple.

Hailuo ne va pas animer la photo chargée, mais plutôt créer une vidéo entièrement nouvelle à partir de votre prompt et de l'apparence de la référence chargée par vos soins.

Il suffit donc d'une photo de vous pour vous téléporter dans le monde entier, dans la situation de votre choix.

Évidemment, pour tester la fonctionnalité, j'ai donné de ma personne (et transféré mon apparence à un développeur chinois, aïe aïe aïe).

Sur une vingtaine de vidéos générées, j'ai trouvé que seul un tiers me ressemblait vraiment (dont cette séquence en kayak). C'est déjà pas mal !

J'ai compilé 7 séquences ainsi générées par mes soins dans cette vidéo tout juste publiée. Jetez-y un oeil et découvrez moi aussi patineur à glace et pilote de voiture de sport !

Petit bémol : on imagine sans mal comment cette fonctionnalité pourrait être utilisée à mauvais escient…

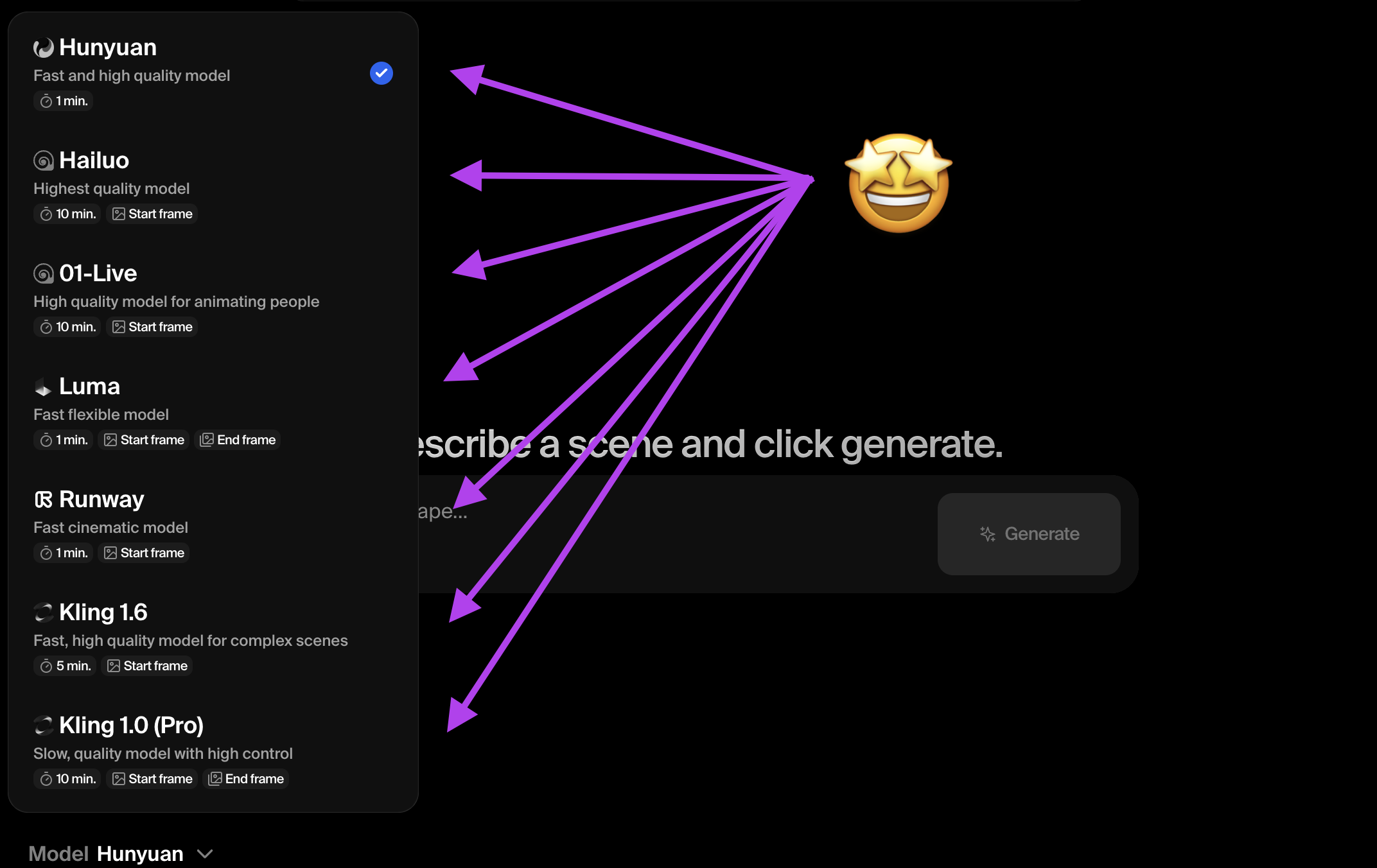

▹ Krea : le nouveau hub de la vidéo IA

Sur Upmynt, je vous relaie les lancements de nouveaux modèles IA : Sora, Veo 2, Hailuo, Runway, Luma… Il y a de quoi s'y perdre.

Et surtout, prendre un abonnement à chacune de ses plateformes vous coûterait un rein, ou en tout cas plus d'une cinquantaine d'euros au total.

La plateforme Krea a la solution : avec son abonnement unique, elle vous donne accès à un max de ces modèles !

(Bien sûr, les plans ne vous donnent pas accès qu'à la vidéo, Krea est une plateforme IA complète avec de nombreux outils, en particulier côté image).

Une fois abonné, vous pouvez donc choisir sur quel modèle procéder. C'est d'autant plus malin que certains modèles se débrouillent mieux sur telle ou telle requête, donc il est judicieux d'en essayer 2 ou 3 pour le même prompt.

Une autre plateforme propose non seulement de choisir votre modèle vidéo, mais aussi de générer une bande-son et même une voix off pour l'accompagner. C'est le prochain outil de cette liste.