▹ News : OpenAI signe un accord avec Condé Nast (Vogue, GQ, Wired)

▹ Zoom : Midjourney accessible depuis le web, lancez-vous !

▹ Deep Dive : Dream Machine 1.5 - enfin un générateur vidéo solide ?

Salut à tous,

J-7 !

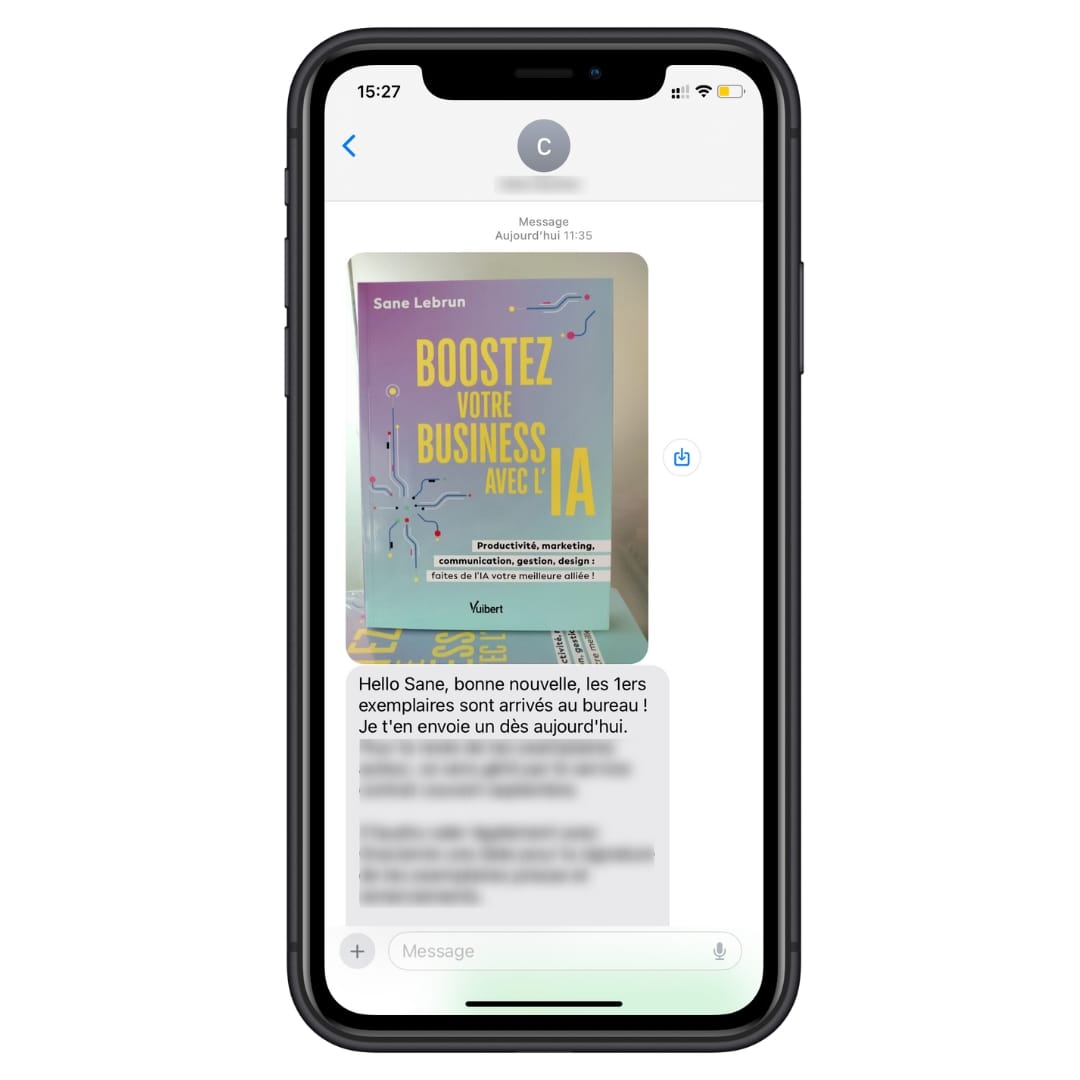

Je vous l'ai annoncé la semaine dernière, mon premier livre "Boostez votre Business avec l'IA" sort dans une semaine… Fun fact : je ne l'ai même pas encore eu entre les mains !

Ce matin, l'éditeur m'a annoncé avoir reçu les premiers exemplaires, preuve à l'appui avec une première photo de l'ouvrage dans sa version physique. Le texto qui fait plaisir :

Je recevrai donc le premier exemplaire physique cette semaine, seulement une poignée de jours avant sa disponibilité.

C'est de l'impression juste à temps ; c'est dire si ce projet aura été mené sur les chapeaux de roue, afin d'être prêt pour cette rentrée 2024.

Après avoir passé des centaines d'heures sur la rédaction de cet ouvrage, c'est peu dire qu'il me tarde de l'avoir enfin entre les mains… 🤩 Puis de le voir entre les mains de ses futurs lecteurs, bien sûr.

Dans l'immédiat, place à cette 151e édition, largement dédiée au générateur vidéo phare du moment : Dream Machine. Bonne lecture !

Sane de Upmynt 💜

🤝 OpenAI x Condé Nast. OpenAI s'est associé à Condé Nast, le conglomérat qui possède les publications Vogue, The New Yorker, GQ et Wired.

Dans le cadre de cet accord, ChatGPT et SearchGPT pourront afficher dans leurs réponses du contenu issu des différentes publications de Condé Nast.

OpenAI affirme que cela permettra aux utilisateurs d'accéder à des « réponses rapides et opportunes avec des sources claires et pertinentes ».

D'autres partenaires ayant signé un deal similaire avec OpenAI incluent Time Magazine, le FT, l'agence Associated Press, et Le Monde.

🧭 La boussole Nvidia. Nvidia publiera ses résultats du 2e trimestre ce 28 août, avec des prévisions de CA et de bénéfice net doublés vs 2023.

Les investisseurs surveilleront de près la croissance des data centers et toute nouvelle annonce sur la puce Blackwell retardée.

Au-delà d'un indicateur sur la santé financière de l'entreprise, c'est tout le secteur IA qui est pendue aux résultats de Nvidia… S'ils sont excellents (comme les précédents), l'euphorie sur les marchés pourra continuer.

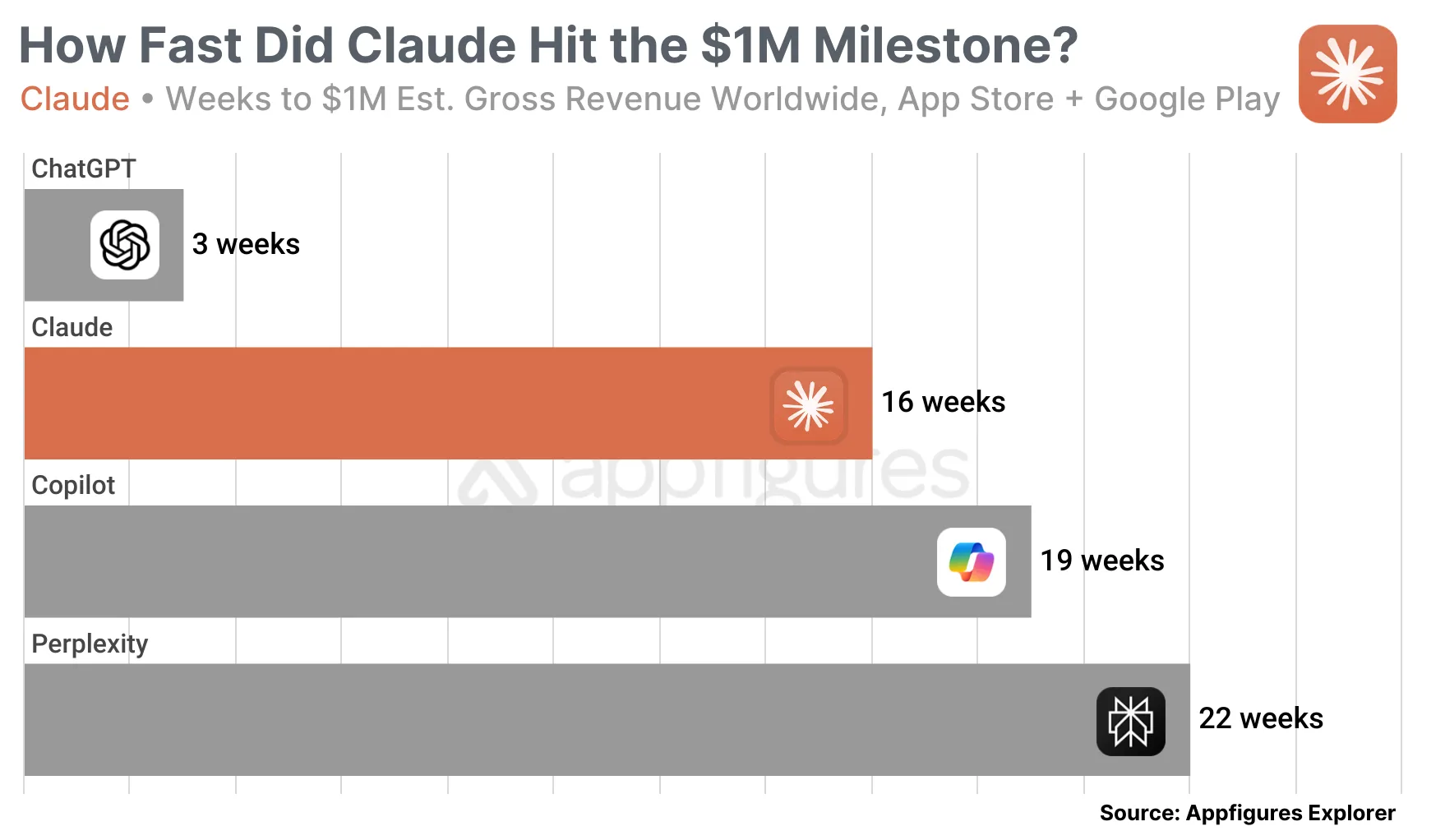

🤑 Jackpot pour Claude. Claude, le chatbot d'Anthropic, a dépassé le million de dollars de revenus sur ses apps iOS et Android, le tout en seulement 16 semaines. Il s'agit des revenus liés aux abonnements Pro contractés depuis l'app.

C'est bien, mais il avait fallu seulement 3 semaines à ChatGPT pour réaliser la même perf.

▹ Job à saisir

La startup française Submagic, à l'origine d'un service d'édition vidéo boostée à l'IA, recherche un créateur de contenu. L'élu deviendra ainsi le visage en ligne de l'entreprise, en charge de la publication de vidéos engageantes sur les réseaux sociaux.

Maitrise de l'anglais nécessaire. Poste à plein temps complètement remote.

Cet espace "Communauté" est le vôtre. Répondez à cet email avec votre besoin : Recrutement, ressource à partager, demande d'aide, question…

Midjourney accessible depuis le web : lancez-vous ! (4 recos)

Midjourney est probablement le générateur que j'ai le plus couvert dans les colonnes d'Upmynt, et je sais que j'ai convaincu nombre d'entre vous de sauter le pas. Deux barrières à l'entrée ont cependant dissuadé nombre d'entre vous : l'absence d'essai gratuit et le passage obligé par Discord.

L'une de ces deux limites vient de sauter : l'interface web vient tout juste d'être (enfin !) rendue accessible à tous les utilisateurs - sans restriction.

Comment essayer Midjourney

Tout internaute peut désormais se rendre sur le site de Midjourney, puis s'inscrire avec son adresse Gmail. Le site propose ensuite trois niveaux d'abonnement, à commencer par un forfait de base à seulement $10 par mois.

Votre première génération sur le site Midjourney

L'interface du site Midjourney, même si elle est bien plus aisée à prendre en main que Discord, peut s'avérer déroutante.

En particulier, une fois inscrit, si vous vous précipitez pour taper votre premier prompt dans la barre du haut "What will you imagine", vous tapez votre essai, et…rien ne se passe. En réalité, la génération a bien été lancé, et vous la retrouverez en vous rendant sur la page "Create" (menu de gauche).

Pour vos premiers pas, consultez aussi ce mini tuto vidéo publié par Midjourney sur X.

4 recos utiles pour améliorer vos rendus sur Midjourney

1️⃣ Sur Midjourney, on prompt de préférence en anglais. Il est possible de prompter en français, mais le générateur peinera souvent à bien comprendre vos requêtes.

2️⃣ Midjourney génère par défaut des images au format carré. Pour changer ça, cliquez sur l'icône "réglages" à droite de la barre de prompt.

Dans ce petit menu utile, retenez aussi que "stylization" permet de booster la patte graphique de Midjourney, entrainé pour proposer des compositions artistiques et des couleurs contrastées.

Si vous n'êtes pas arrêté sur un style précis, laissez Midjourney vous impressionner en augmentant cette valeur, par exemple jusqu'à 500.

3️⃣ Ambiance, lumière, époque, style graphique… Pas facile de penser à tout. Ce prompt builder vous permet de sélectionner parmi de nombreux choix, avec l'aide d'échantillons correspondants. Ne sélectionnez que ce qui importe pour votre génération.

4️⃣ Exploitez ce paramètre magique : --q 2.

Depuis la dernière version de Midjourney (v6.1), vous pouvez booster la qualité du rendu en utilisant le paramètre "--quality" ou "--q" avec une valeur 2. Pour ce faire, ajouter simplement "--q 2" à votre prompt. Par défaut, le paramètre qualité est à 1.

Observez par exemple ce prompt et le résultat :

Macro view of a cute spider --q 2

Attention, l'usage du paramètre --q à la valeur 2 grignote davantage votre crédit mensuel qu'une génération classique.

Dream Machine 1.5 - enfin un générateur vidéo solide ?

À sa sortie, le générateur vidéo Dream Machine de Luma avait fait sensation… Puis il a été partiellement éclipsé par le nouveau Runway.

La version 1.5 de la Dream Machine vient de sortir. Il promet des améliorations d'animation et de rendu à tous les étages. Qu'en est-il vraiment ?

▹ Comment accéder à la machine à rêve

Pour rappel, vous pouvez essayer gratuitement la Dream Machine.

Cependant, il vous faudra attendre entre 1h et 24h (durée aléatoire) pour chaque génération. Vous pouvez lancer simultanément 2 générations seulement. Ce peut être fastidieux, car il est rare que le premier jet soit le bon.

Le premier plan "Lite" commence cependant à $9,99 (vs $15 chez Runway).

▹ Text-to-video : surtout performant avec les paysages et objets

Les générateurs vidéo fonctionnent mieux avec un prompt image, car cela constitue une base solide à simplement animer. À l'inverse, un simple prompt texte constitue un défi autrement plus élevé : proposer une composition crédible et un rendu réaliste, en plus d'une animation vraisemblable.

Cette version 1.5 de Luma prétend précisément s'être amélioré sur ce front. Qu'en est-il vraiment ?

J'ai réalisé une dizaine d'essais, et mon constat est sans appel :

- Le résultat reste le plus souvent imparfait. Dès lors que l'on souhaite représenter des êtres vivants (humains ou animaux), les "bugs" d'affichage sautent aux yeux et rendent le plus souvent les animations inutilisables. Luma a aussi tendance à générer des mouvements de caméra un peu chaotiques. Illustration avec cette séquence d'une abeille butinant un tournesol.

Mais de ce point de vue, et pour avoir testé le même prompt, Runway (solution leader) rencontre exactement le même problème.

- Toutefois, dès lors que l'on opte pour des représentations moins figuratives, Luma se révèle plus performant… Peut-être parce l'œil humain est moins enclin à repérer les rendus ou animations chaotiques sur des objets et paysages que sur des sujets.